千葉工業大学情報科学部情報工学科の多感覚情動情報処理研究室(有本研究室)です。

人間のマルチモーダルな情報から感情とコミュニケーションを計算可能にする研究を行っています。

What’s new?

にてB4の木澤妃名子さんが発表した研究が2024年度ヒューマンコミュニケーション基礎(HCS)研究会賞を受賞しました。おめでとうございます!

Yoshiko ARIMOTO's Lab from Chiba Institute of Technology

千葉工業大学情報科学部情報工学科の多感覚情動情報処理研究室(有本研究室)です。

人間のマルチモーダルな情報から感情とコミュニケーションを計算可能にする研究を行っています。

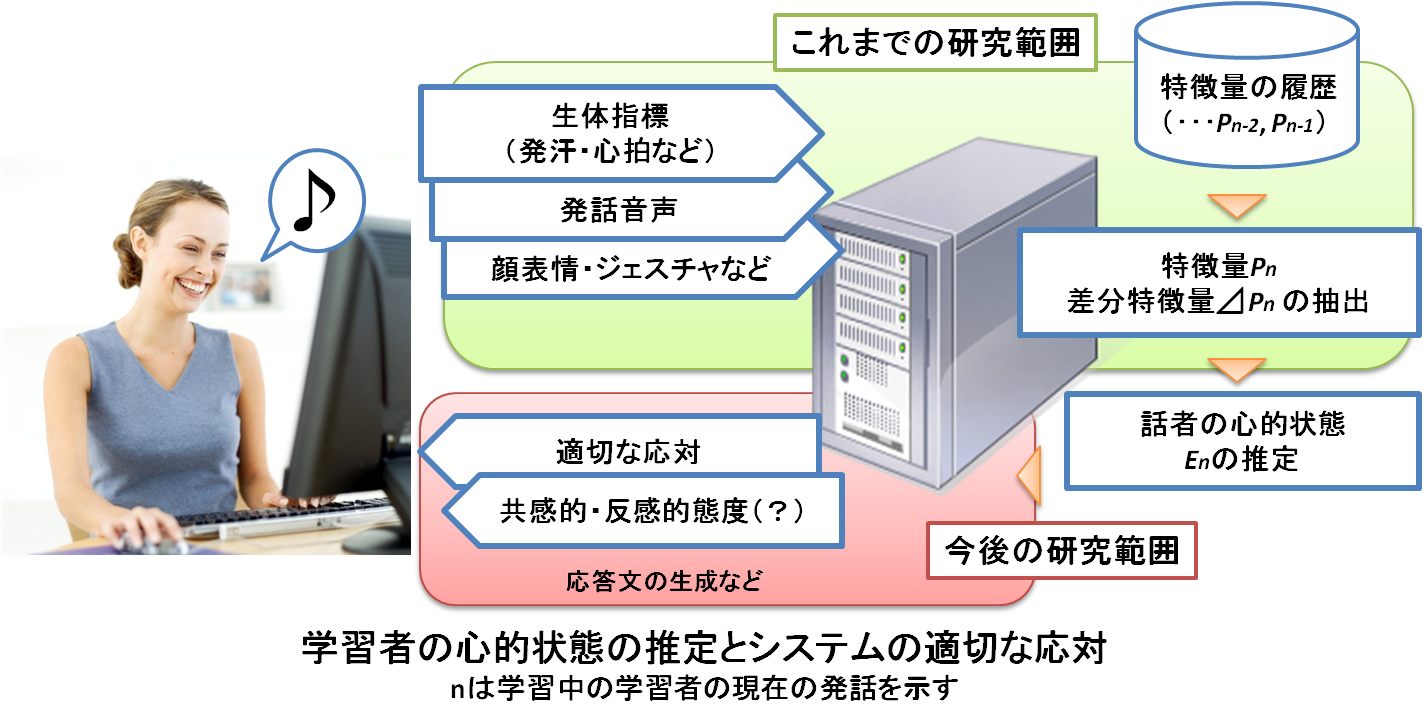

感情の情報工学的な研究と、認知的・心理学的研究の両方を行う文理融合型研究を行います。コミュニケーション場面を研究対象とすることで、感情の表出や知覚に利用される表情や音声・生理反応を個別に分析するだけではなく、それらを統合的に分析し、システムの精度向上を図る仕組みを考えます。人間が発信する多くの情報を研究対象とするため、研究を通して、音声処理・言語処理・信号処理・画像処理・プログラミング・音響学・音声学・言語学・心理学・生理学・統計学などの多くの分野の知識を身につけることができます。

工学的研究

認知科学的研究

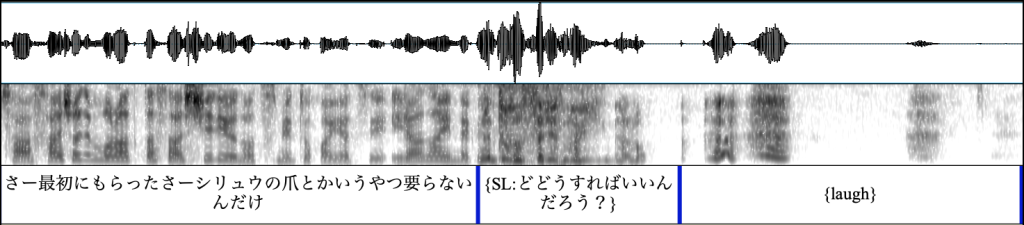

本研究は,これまでに研究されてこなかったspeech-laughの発生機序の解明に挑戦する世界初の研究です。Speech-laughとは,発話中に肺からの突発的な呼気流により生じるしゃべりながらの笑い声のことで,声道を調音器官として使って言語情報を形成すると同時にその声道から笑い声を生成するという音声的にも音響的にも複雑な構造をもっています。これまでの音声工学・音声科学の研究では,その複雑な構造のためにspeech-laughを対象とした研究は行われず,いつ・どこからspeech-laughが発声されるのかは不明なままでした。本研究では,さまざまな日常場面における音声コーパスを使用し,音声学的・音響学的手法によって,発話中である話者がどのような声道形状で調音をした際にspeech-laughが発生しやすいのかを解明します。本研究によってspeech-laughの発声機序が明らかとなれば,ロボットやキャラクターエージェントなどとの音声対話システムにおいて,システム側のspeech-laughの発声タイミングを制御することが可能となり,より自然なspeech-laugh合成が可能となります。

本研究の目的は,自然性が高く表現豊かな笑い声・叫び声の合成を実現することです。深層学習の登場によりテキスト音声合成の技術は飛躍的に進歩し,読み上げ音声であれば人間の話し声と全く区別がつかないレベルに達しています。一方で,自発対話音声の合成音声は自然性が低く,特に「ハハハ」といった笑い声や「うぉー」といった叫び声などの突発的な感情表現の合成は未だ困難な課題となっています。対話中では,回答しづらい質問に対して笑い声で曖昧に応答したり,多人数でゲームを観戦する際に共に歓声をあげることで他者との一体感を得たりするため,笑い声や叫び声は非常に重要な役割を担います。本研究により人が発する笑い声や叫び声のような自然性の高い合成音声を実現できれば,例えば気管切開や喉頭摘出により声を失った人たちが自然に笑い声や叫び声をあげられるようになり,言語情報のみでは表現できない豊かな音声コミュニケーションを取り戻すことができるようになります。

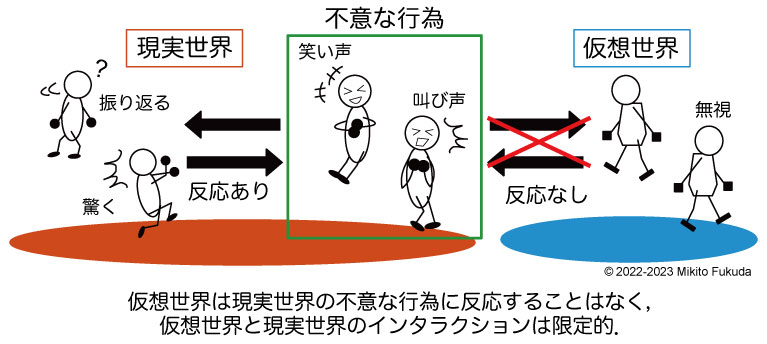

ヴァーチャル世界を利用中に無意識に表出する現実世界の感情を入力とし,アバターの状態を,ユーザの意図に関わらず強制的に変更システムの開発を目指します。本システムにおける感情表出は音声に含まれるAffect Burstを対象とします。Affect Burstとは音声の非言語的使用による感情の急激な表出のことで,無意識な叫び声や笑い声,泣き声や,「ゲッ」「おお!」など言語音として意識的な制御下にあるものを含みます。ユーザが思わず発する様々なAffect Burstを,その音響的・言語的特徴から機械学習によって検出する仕組みを構築するとともに,検出した表出感情に対して動作させる仮想世界内のイベントの適切な組合せを,評価実験を行って検証します。自分自身の無意識な感情表出を制御しないと,仮想世界内のアバターに影響が及ぶシステムの構築により,アバターとの一体感を向上させ,よりリアルなバーチャル空間を実現します。

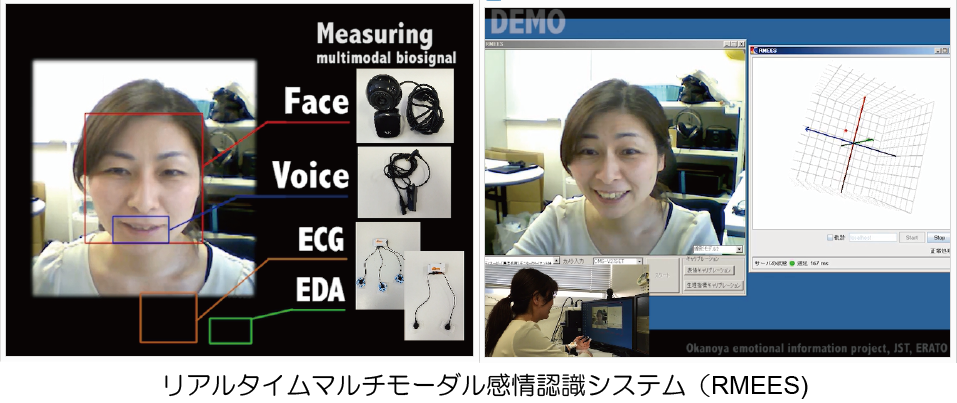

オンラインコミュニケーション場面では,映像・音声・テキストなど媒介するコミュニケーションメディアの違いにより,表情や声の抑揚などの非言語情報が消失し,伝達される情報に欠落が生じています。オンライン場面でも現実世界の対面場面と同等の感情コミュニケーションを実現するためには,非言語情報を利用してオンラインコミュニケーション手段を人間的に拡張する新規な情報表現へと変換し,欠落する感情を補完する仕組みが必要です。本研究では,オンラインコミュニケーション環境下で意識的・無意識的に抑制されうる表情や音声などの情報だけでなく,抑制不可能な自律神経系反応などの情報を利用して,感情をリアルタイムに推定するマルチモーダル感情推定システムを開発します。 (デモ動画はこちら)

マン―マシン間の双方向的な感情インタラクションの実現を目指し,話者を対話に没入させ,感情表出の頻度および強度を人間同士の対話に近づけるコンピュータの振る舞いを明らかにします。人間同士の双方向的な感情コミュニケーションのひとつである表出行動の模倣に着目して,話者のマルチモーダルな表出行動をコンピュータに模倣させることでマン―マシン間の双方向的な感情インタラクションを実現していきます。

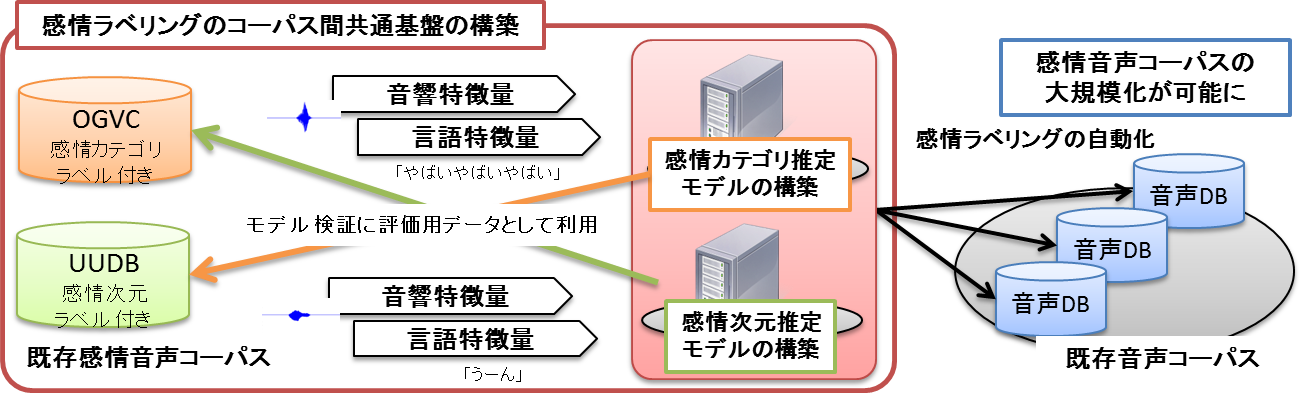

大規模音声コーパスを必要とする音声認識や感情認識などの人間と機械との対話の円滑化を念頭にした研究では,複数のコーパスを併用することが求められています。しかし,コーパスごとに独自基準で感情ラベリングを行っているため,感情ラベルをコーパス間で等価とみなすことができず,現状では複数コーパスの併用は不可能となっています。本研究では,現在人手により付与されている感情ラベリングを自動化することで,コーパス間で共通した感情ラベルを自動付与し,感情ラベルにおけるコーパス間共通化基盤の確立を目指します。これにより,研究の資料として利用できる音声資源が爆発的に増加し,人間と機械との対話における感情研究の発展が見込まれます。

本コーパスは2種類の感情音声で構成されています。ひとつは対話中に自然に表出した感情を含んだ自発対話音声であり,もうひとつは従来の感情音声研究で用いられてきた演技による感情音声です。自発対話音声では,Massively Multiplayer Online Role-Playing Game(MMORPG)と呼ばれるオンラインゲームを対話収録に導入することで自発的で活き活きとした感情を誘発しました.さらに,ゲーム中のプレーヤー同士に音声チャットによるコミュニケーションを行なわせることで,誘発した感情が音声に反映されるように工夫しました.本手法により,自然に表出した感情を含んだ自発対話音声9,114発話を収録しています。演技による感情音声は,感情表現が得意と考えられるプロの俳優に演じさせたものです。音声収録時に使用した発話テキストは,自然な対話で収録した発話の転記テキストから選択しています。発話単位で表現させる感情とその強度を指定して,プロの俳優4名に感情を込めて発声させ,計2,656発話を収録しています。本コーパスはNII-SRCより配布されており,2022年12月末時点で305件の配布実績があります。 開発したコーパスを利用し,「Affect Burst(笑い声・叫び声)合成」「プレイヤー自身の感情制御を余儀なくされる対戦型ゲームの開発」や「感情音声におけるコーパス間共通規格の確立と自動感情ラベリングの手法の構築」の研究を行っています。 (OGVCのページはこちら)